#1/3 - Premier article de la série GenAI

La dernière révolution que nous avons connue dans le monde de la Data de 2019 : c’est l’apparition de la Modern Data Stack. À l’époque, cette nouvelle approche représentait une avancée majeure dans la manière de construire des projets Data, avec de nombreuses promesses :

- Une meilleure autonomie des équipes métiers grâce à une adoption facilitée des outils et des données de meilleure qualité

- Un Time-To-Insights amélioré

- Une qualité de données renforcée grâce aux solutions de gouvernance et d’observabilité

- Une architecture plus flexible et évolutive grâce au Cloud Une meilleure maintenabilité des pipelines avec une approche SQL First

C’est dans ce contexte que nous avons créé Modeo, avec une mission claire : aider nos clients à réaliser avec succès des projets ambitieux en s’appuyant sur cette nouvelle stack.

Pour concrétiser cette vision, nous avons développé une forte expertise en Data Engineering, constitué une équipe de plus de 30 Data Engineers, et accompagné plus d’une centaine de clients, de toutes tailles et dans des secteurs très variés. C’est comme cela que Modeo est devenu la référence française de la Modern Data Stack.

Ces projets nous ont permis de comprendre ce qui fonctionne – ou non – au sein d’une équipe Data pour construire des cas d’usage à forte valeur, avec de nombreux acteurs impliqués. Ils nous ont aussi aidés à identifier les principaux enjeux à résoudre, qu’ils soient techniques, organisationnels ou liés aux process.

----

Alors comment cette nouvelle révolution "la GenAI" va impacter les équipes Data ?

C’est pour cette raison que j’ai décidé de rédiger une série d’articles, en soulevant 3 questions :

- Comment seront construites les Data Platform de demain ?

- À quel point les équipes Data vont être transformées ? Doit-on imaginer un monde où les équipes Data n’existent plus ?

- Comment une équipe Data doit tirer profit de la GenAI ? Quels sont les risques ?

Disclaimer : cette vision s’appuie uniquement sur mon opinion personnelle ainsi que sur des échanges menés en interne chez Modeo. Notre compréhension du fonctionnement des équipes Data se limite à un contexte européen. Elle n’a en aucun cas vocation à représenter une vérité absolue, ni à s’appliquer de manière uniforme à toutes les organisations. Chaque contexte Data est unique, et les réflexions partagées ici doivent être adaptées aux réalités propres à chaque entreprise.

1. Comment seront construites les Data Platforms de demain ?

1.1 - Les innovations clés

• Vibe coding & copilots

Qu’est-ce que le vibe coding / un copilote ?

Le 'vibe coding' est une nouvelle manière de coder rendue possible par l’arrivée de l’IA dans les outils data.

Concrètement, cela désigne une expérience de développement où le Data Engineer est assisté par des copilotes intelligents, qui :

• comprennent le contexte,

• génèrent du code,

• proposent des corrections ou des suggestions,

• permettent de travailler plus vite, avec moins de frictions.

On ne part plus d’une page blanche. On décrit ce qu’on veut faire, l’outil propose une première version, puis on ajuste.

Le tout se déroule dans une interface pensée pour faciliter l’expérimentation, le test et l’itération.

Ce n’est pas un changement de métier, c’est un changement de rythme : plus fluide, plus intuitif, plus centré sur la logique métier.

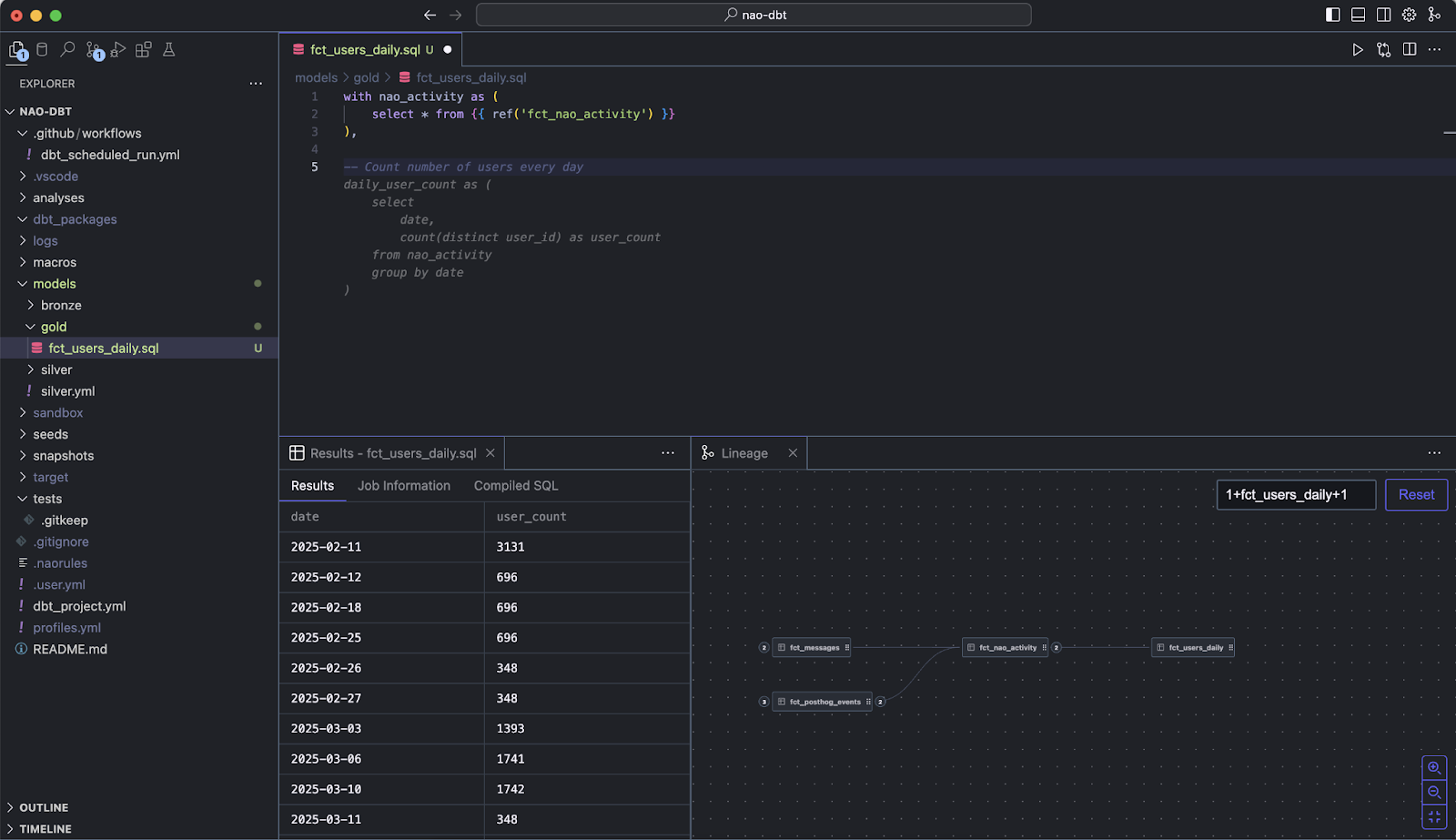

Exemples d’IDE permettant de “vibe-coder” : Nao ; Cursor ; Windsurf

• MCP : Model Context Protocol

Qu’est-ce qu’un MCP ?

Le Model Context Protocol (MCP) est un standard ouvert qui permet aux IA (comme les copilotes) d’accéder facilement aux données d’une entreprise, qu’elles soient dans Google Drive, Slack, GitHub ou une base de données.

Plutôt que de créer une intégration spécifique pour chaque outil, MCP propose un protocole unique pour connecter l’IA à toutes les sources utiles.

Résultat : plus besoin de multiplier les connecteurs personnalisés. L’IA peut naviguer d’un outil à l’autre en gardant le contexte métier.

Comment ça fonctionne ?

Dans une application, le principe est simple :

• L’IA ne se connecte pas directement à vos outils ou bases de données.

• Elle interagit avec un MCP Server, qui expose un point d’entrée unique pour accéder aux données.

Un server MCP standardise la méthode de connexion via un protocole universel :

• il décrit les données disponibles sous forme de JSON,

• expose les actions possibles (lire un fichier, interroger une table, etc.),

• permet à l’IA de comprendre ce qu’elle peut faire, dans quelles limites, et avec quel niveau de permission.

L’IA lit ce fichier de contexte (un JSON enrichi de schémas et métadonnées), qui joue le rôle de carte d’accès aux différentes API ou ressources métiers.

Avec MCP, l’IA peut alors :

• lire des documents ou objets métier via une API REST ou GraphQL,

• poser des questions contextuelles (“quelles sont les dernières anomalies dans ce tableau de monitoring ?”),

• générer des requêtes sur mesure (SQL, API call, transformation) selon la structure exposée.

Le tout dans un cadre sécurisé, contrôlé et interopérable avec plusieurs systèmes.

📎 En savoir plus sur le Model Context Protocol : https://modelcontextprotocol.io/overview

• AI Agent

Qu’est-ce qu’un AI Agent ?

Un AI Agent est une IA autonome, reliée aux données et aux outils, capable de :

• comprendre un besoin métier,

• accéder aux bonnes données,

• les transformer,

• produire un résultat exploitable,

Et ce, sans pipeline figé ni transformation écrite à la main à l’avance. C’est une nouvelle manière de penser l’automatisation dans les équipes Data.

Un agent active des “micro-compétences” spécialisées (appelées aussi “agents”) en fonction du besoin :

• un agent de parsing va lire un fichier brut (CSV, JSON),

• un agent de nettoyage corrige les valeurs manquantes ou les doublons,

• un agent de transformation calcule des agrégats ou reformate les données,

• un agent d’ enrichissement ajoute des informations externes (ex. : données géographiques),

• un agent de mapping fait correspondre deux schémas de données différents.

Ces agents peuvent travailler de façon coordonnée, comme une équipe autonome qui construit un pipeline de traitement sans règles codées à l’avance, mais en s’adaptant au contexte.

• Self-healing pipelines

Qu’est-ce qu’un self-healing pipeline ?

Les self-healing pipelines ou pipelines auto-réparateurs sont des workflows de données capables de :

• détecter automatiquement une erreur,

• en identifier la cause probable,

• exécuter une action corrective,

Et ce, sans intervention humaine.

Ce ne sont pas de simples systèmes d’alerte ou de monitoring.

Le pipeline est capable d’agir de lui-même :

• redémarrer une étape,

• corriger une valeur incohérente,

• changer de source temporairement,

• désactiver une transformation problématique,

… tout en logguant automatiquement ce qu’il a fait.

• Multi-Agent Platform

Qu’est-ce qu’une Multi-Agent Platform ?

Une plateforme multi-agent permet de faire collaborer plusieurs agents d’IA autonomes dans un même environnement, chacun étant responsable d’une partie spécifique d’un processus complexe.

Ces agents :

• partagent un objectif commun, défini en amont par l’utilisateur ou le système,

• se répartissent les tâches selon leurs rôles et compétences,

• s’échangent des informations intermédiaires (résultats partiels, fichiers, contexte, données extraites),

• peuvent adapter leur comportement en fonction des résultats produits par d’autres agents,

• fonctionnent de manière orchestrée, via un moteur central qui assure coordination, suivi et progression vers l’objectif final.

C’est une logique de collaboration asynchrone ou séquentielle, mais contextualisée :

chaque agent travaille dans un cadre structuré, avec des responsabilités bien définies, et peut prendre des décisions en autonomie dans les limites de son rôle.

2 - Ce qui va changer : analyse brique par brique

2.1 — Ingestion des données

L’IA va repenser la façon dont nous construisons nos pipelines d’ingestion grâce au vibe coding. Ces outils intelligents auto-généreront du code, soumis à la validation du développeur.

Pour s’intégrer à une Data Platform, ce code généré devra s’appuyer sur des standards prédéfinis par l’entreprise. Autrement, il s’agira d’une agrégation de bout de codes sans aucune cohérence. Le rôle de l’équipe Data Platform (ou DataOps / Centre d’Excellence) sera crucial pour fixer des standards et s’assurer qu’ils soient respectés.

Concernant les MCP, je ne suis pas convaincu qu’ils remplacent les méthodes d’ingestion traditionnelles. Ce n’est pas ici qu’est la valeur du MCP qui fonctionne comme un ETL :

- Je me connecte à un système et je récupère des données

- Je transforme ces données

- Je les restitue au format attendu.

Si aujourd’hui les équipes Data privilégient une approche ELT vs ETL, c’est pour entre autres passer par une couche centrale de transformation, type architecture médaillon, pour “figer” la connaissance métier.

Ces couches sont la résultante des différentes itérations métier / tech.

La modern data stack s’est conçue en isolant chaque brique pour des raisons de simplicité, de flexibilité et d’évolutivité. Revenir en arrière avec une approche 100% ETL serait contre-productif.

Il est en revanche certain que les éditeurs de solutions (Salesforce, Hubspot, Google Analytics…) adapteront leurs produits pour maximiser la compatibilité avec des outils IA type MCP et améliorer l'expérience utilisateur. C’est un levier de compétitivité.

Cela n’est pourtant pas bien nouveau. En effet, il est déjà possible de le faire via API ou interface graphique. En revanche, cette approche sera plus accessible pour les métiers, et sera donc utilisée pour des analyses ad-hoc.

Exemple : “donne-moi le panier moyen sur l’offre X”.

Cette approche MCP a également l’avantage de proposer de la donnée fraîche, avec un temps de latence minime. En revanche, elle ne permet pas de figer des analyses ni d’y intégrer des règles de métier complexes (exemple de la notion de “availability” chez Airbnb).

Les équipes Data devront donc rivaliser avec des analyses Ad-Hoc, en proposant de la donnée de qualité, fraîche, à forte valeur ajoutée avec une très bonne expérience utilisateur. Elles devront également mettre en place le bon cadre pour veiller à ce que ces analyses ad-hoc soient réalisées sous leur supervision pour éviter des problèmes de silos, souvent déjà bien présents.

KPIs impactés par l’IA :

- Robustesse des pipelines d’ingestion => réduction du nombre d’incidents

- Temps requis pour intégrer une nouvelle source de données

- Harmonisation du code généré

2.2 - Transformation

Son objectif est de faire passer les données brutes à un état exploitable, en les rendant fiables, compréhensibles et activables pour les équipes métier. C’est ici qu’on construit les KPIs de l’entreprise.

Tout comme l’ingestion, le développement de script de transformation de données va être grandement accélérée grâce au vibe-coding :

- Exploration et compréhension des données : Avant même la construction des pipelines, l’équipe Data accélèrera considérablement la phase d'exploration des données grâce à l’IA. Elle peut s’appuyer sur un agent pour identifier des valeurs manquantes, des distributions de données ou de la documentation des métadonnées qui répond à des questions en langage naturel, par exemple : "Y a-t-il des métadonnées disponibles qui documentent la source et les types de données de chaque colonne ?".

- Génération de requêtes SQL et autocomplétion : Grâce aux LLM spécifiques à une tâche, les copilotes peuvent même générer du code SQL en réponse à des questions en langage naturel, ce qui permet de gagner du temps et d'obtenir rapidement des informations. Ils peuvent également optimiser les requêtes SQL pour améliorer les performances et la lisibilité.

Les équipes Data seront donc équipées d’IDE intelligents, comme Nao pour produire du code de transformation, type DBT. En produisant plus rapidement (jusqu’à 10x plus vite selon Olivier Laslett, CTO de Lightdash), les itérations entre les équipes métier et Data seront plus rapides ce qui permettra de construire des produits Data plus personnalisés avec plus d’impact avec une équipe plus restreinte. Le métier de Data Analyst va être profondément impacté par ces innovations, mais nous en parlerons plus tard.

KPIs impactés par l’IA :

- Vitesse de développement / Time-To-Insights

- Qualité des analyses produits

- Autonomie des équipes métier

- Harmonisation des standards de développement

2.3 - Stockage

Le modèle dominant du Data Warehouse - centralisé, figé, coûteux à adapter - a montré ses limites face à la croissance des volumes, à la diversité des cas d’usage, et à l’augmentation croissante des sources, des formats et des usages. L’émergence du Data Lakehouse, en réponse à ces contraintes, a déjà ouvert la voie vers des plateformes plus unifiées, capables d’adresser à la fois des besoins analytiques traditionnels et des usages ML/IA, avec des capacités de personnalisation beaucoup plus importantes.

Beaucoup de nos clients fonctionnaient encore avec un SQL en guise de Data Warehouse. Ce n’est plus possible en 2025 :

- moteur inadapté à des cas d’usages Analytics et IA

- expérience de développement limitée

- manque de scalabilité

La majorité des projets Data & IA s’appuieront sur les solutions suivantes :

- Snowflake : plateforme de données SaaS cloud qui s’impose comme un composant central des architectures composables. Elle combine scalabilité dynamique, séparation du calcul et du stockage, adoption des formats ouverts comme Iceberg et intégration fluide dans des environnements hybrides. Idéale pour les workloads analytiques haute performance tout en s’ouvrant aux usages IA et temps réel.

- Databricks : plateforme Lakehouse orientée data science et machine learning, optimisée pour la manipulation de données brutes et semi-structurées, l’entraînement de modèles et le traitement distribué à grande échelle. Son intégration native avec Delta Lake et ses APIs ouvertes en font un choix privilégié pour les projets IA complexes.

- ClickHouse : moteur analytique orienté colonnes ultra-performant, conçu pour l’interactivité sur des volumes massifs. Très apprécié pour les cas d’usage BI temps réel, monitoring, observabilité et analytics opérationnel, grâce à ses temps de réponse extrêmement courts.

- Trino / Iceberg : combinaison d’un moteur de requête distribué (Trino) et d’un format de table ouvert (Iceberg) permettant d’interroger les données là où elles résident, sans duplication. Offre une flexibilité maximale pour composer un écosystème data interopérable, tout en réduisant les coûts liés aux mouvements de données.

Ces choix technologiques devront être réalisés en tenant compte des contraintes fortes telles que :

- les coûts de la solution

- la gouvernance légale / RGPD et règle appliquée en matière de traitement de données sensibles

- la sustainability

KPIs impactés par l’IA :

- Optimisation du stockage

- Coût de stockage par projet

- Autonomie des équipes métier

2.4 - Orchestration

L’orchestration est la brique qui permet d'exécuter des scénarios de traitement de données : elle décide quand et dans quel ordre chaque tâche doit s’exécuter, s’assure que toutes les dépendances sont satisfaites, réserve les ressources nécessaires (CPU, mémoire, GPU…), surveille l’avancement et gère les éventuelles erreurs pour que l’ensemble du flux arrive à son terme. Dans une architecture de données moderne et distribuée, elle joue un rôle stratégique : garantir que l’ensemble des traitements -ingestion, transformation, analyse, IA - s’exécutent dans le bon ordre, avec la bonne capacité de calcul, au bon moment.

À court terme, ces orchestrateurs seront en mesure de fournir une interprétation de la source d’un incident, facilitant ainsi le "débogage" pour une équipe Data.

A plus long terme, les orchestrateurs de demain utiliseront l’IA pour générer des scénarios de traitement de données qui seront plus statiques et fixés en amont mais dynamiques : des agents analyseront en continu l’état des pipelines et du système, détecteront des anomalies avant qu’elles ne causent un incident, ajusterons l’ordre d'exécution des tâches et l’allocation des ressources en temps réel, et déclencheront automatiquement des actions correctives pour résoudre des incidents.

Ces agents intelligents ne se limitent plus à de la surveillance :

- Self-healing pipelines : en cas d’erreur, le pipeline est capable de diagnostiquer la cause probable (source indisponible, transformation en échec, données incohérentes), puis de prendre une mesure corrective : relancer une tâche, basculer temporairement sur une autre source, corriger une valeur ou mettre en pause une étape problématique. Tout est loggué, offrant traçabilité et contrôle.

- Aide à la génération de DAG : via le vibe coding, les équipes peuvent décrire un flux en langage naturel et obtenir un DAG généré automatiquement. L’IA peut aussi proposer des optimisations, améliorer la lisibilité ou simplifier la maintenance.

Cependant, cette puissance impose des garde-fous :

- Un socle robuste doit être fourni par l’équipe DataOps, incluant des standards de développement, des modèles de DAG pré validés, et des processus de déploiement et de tests automatisés. Ces standards permettent de s’assurer que les pipelines générés respectent les bonnes pratiques : fiabilité, observabilité, reprise sur erreur, compatibilité multi-environnements.

- Les agents peuvent aller jusqu’à générer des DAGs, ouvrir des pull requests et proposer des revues de code. Reste à définir, pour chaque organisation, le degré de contrôle humain : validation systématique par un Data Engineer ou déploiement autonome dans certains cas maîtrisés.

Reste à savoir si les éditeurs de solution d’orchestration type Airflow ou Dagster intègreront ce type de solutions dans le produit, ou s’il sera de la responsabilité des équipes Data de les développer. Comme cela a pu être vu pour d’autres solutions, il est probable que ce type de features soit intégré dans les offres payantes et ne soit donc pas disponible dans les versions open source.

La brique d’activation correspond à la mise à disposition des données auprès des équipes métier, pour qu’elles puissent les exploiter dans leur quotidien. C’est ici que la donnée prend toute sa valeur, lorsqu’elle est traduite en insights actionnables via différents canaux : outils de visualisation (dashboarding), interfaces d’exploration libre (self-service analytics), exports automatisés vers les outils opérationnels (CRM, marketing automation…) ou encore intégration directe dans des applications métier.

KPIs impactés par l’IA :

- Autonomie des équipes métier

- Qualité des données

- Impact des équipes Data

2.5 - Data activation & Analytics

2.5.1 — L’évolution rapide des outils d’analytics

Historiquement, la donnée était consommée via des tableaux de bord figés, nécessitant des compétences techniques pour produire de nouvelles analyses. Aujourd’hui, deux tendances fortes transforment cet usage :

- Les solutions de dashboarding classiques évoluent

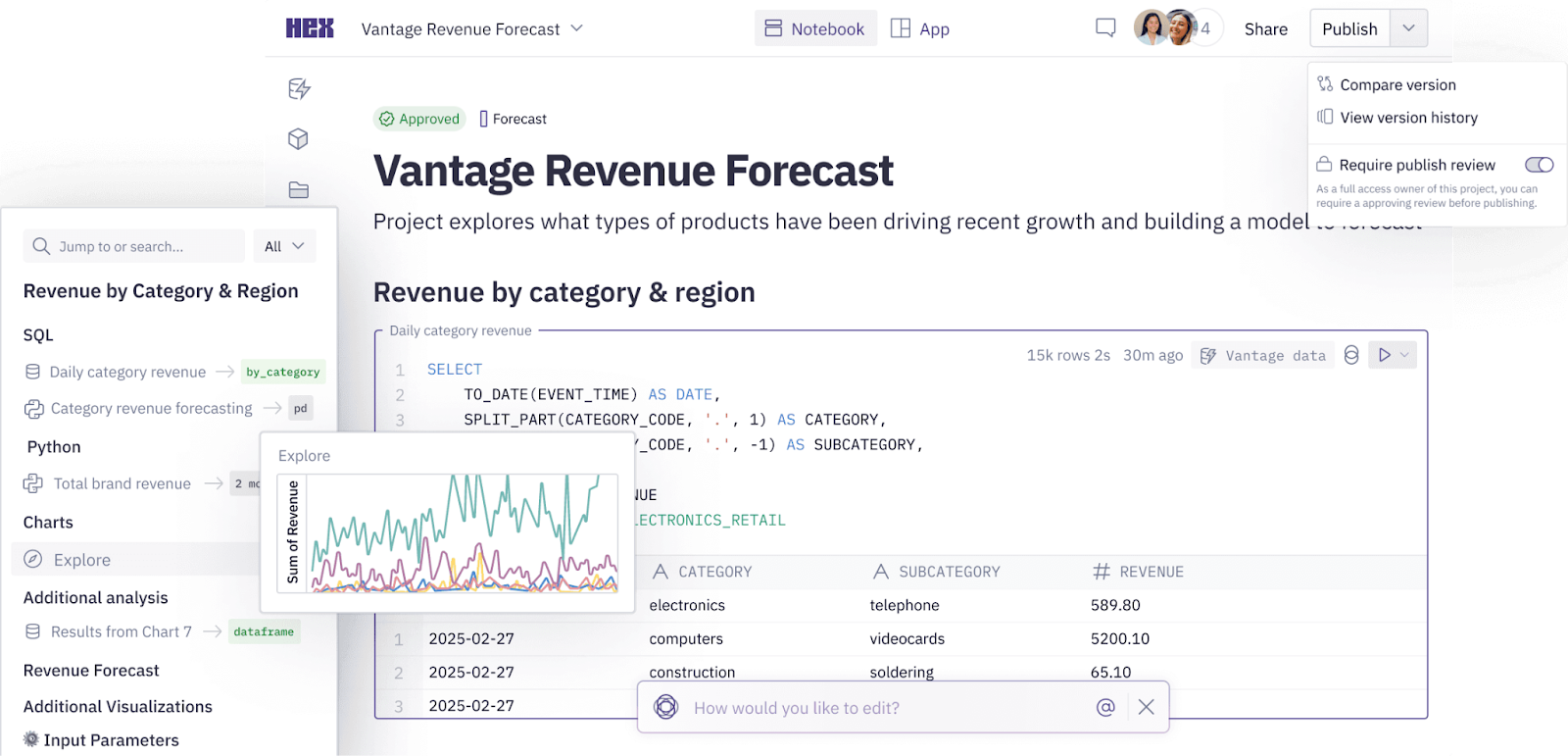

Des acteurs établis comme Tableau, Power BI ou Looker ajoutent des fonctionnalités de chat permettant d’interroger les données en langage naturel. L’utilisateur peut poser une question (“Quelles sont les ventes mensuelles en France sur le dernier trimestre ?”) et obtenir non seulement la réponse, mais aussi la visualisation associée. Certaines solutions vont plus loin en proposant la génération de graphiques ou de requêtes avec du code produit par un copilote IA, facilitant l’analyse ad hoc. - L’émergence de plateformes analytiques avancées

De nouveaux outils, comme Hex ou Mode, permettent de réaliser des analyses croisées et exploratoires directement sur le Data Warehouse. On ne se limite plus à des requêtes descriptives (“retrouve-moi la liste des ventes par pays”), mais on passe à des analyses explicatives ou prédictives (“identifie les facteurs qui influencent les ventes en Espagne au dernier trimestre”). Ces solutions s’adressent aux analystes comme aux profils métier avancés, en leur donnant accès à un environnement flexible, collaboratif et connecté aux sources de vérité.

2.5.2 — Vers des “niveaux d’autonomie” des analyses

Comme pour les voitures autonomes, on peut définir plusieurs paliers d’automatisation dans l’analytics :

- Niveau 0 – No automation :

l’utilisateur doit connaître le modèle de données et écrire lui-même ses requêtes.

- Niveau 1 – Automatisation du requêtage :

l’IA génère automatiquement les requêtes vers le Data Warehouse à partir de questions en langage naturel.

- Niveau 2 – Guided insights :

l’IA suggère des visualisations pertinentes ou des pistes d’analyse à partir d’un jeu de données choisi.

- Niveau 3 – Proactive analytics :

l’IA détecte et signale automatiquement des anomalies, tendances ou opportunités, sans requête préalable.

- Niveau 4 – Autonomous decision support :

l’IA recommande directement des actions à entreprendre, en s’appuyant sur l’ensemble des données disponibles et les objectifs de l’entreprise.

⚠️ Attention : ces outils sont encore jeunes et l’approche LLM reste questionnable dans sa capacité à construire des raisonnements avancés basés sur de l’analyse.

2.5.3 — Les prérequis côté Data

Pour tirer pleinement parti de ces nouvelles capacités, les équipes Data doivent disposer d’un Semantic Layer de qualité :

• Une couche centralisée, de taille maîtrisée, contenant les KPI clés de l’entreprise.

• Des données nettoyées, précalculées et documentées, garantissant leur qualité et leur cohérence.

• Une documentation avancée (définitions métier, provenance, méthodes de calcul) afin que l’IA et les utilisateurs humains interprètent correctement les résultats.

Permettre aux équipes de faire de la self-BI fait partie des enjeux majeurs de nos clients. Mais les outils actuels sont souvent trop complexes pour les utilisateurs non techniques. Ces nouvelles approches devraient casser ces verrous et démultiplier l’impact des équipes métier en leur donnant plus d’autonomie.

KPIs impactés par l’IA (Semantic Layer) :

• Autonomie des équipes métier,

• Qualité des données,

• Impact des équipes Data.

2.6 - Gouvernance et observabilité

Dans une Data Platform moderne, la gouvernance correspond à l’ensemble des règles et mécanismes mis en place pour garantir une gestion efficace, fiable et maintenable des données.

Elle s’exerce sur cinq dimensions complémentaires :

• Métier : définition claire et partagée des KPIs pour éviter toute ambiguïté.

• Business : alignement entre usages de la donnée et priorités stratégiques.

• Légal : conformité réglementaire (RGPD, AI Act…), respect de la confidentialité.

• RSE : prise en compte des enjeux éthiques et environnementaux.

• Tech : respect des bonnes pratiques d’architecture, de sécurité, de qualité et de performance.

L’observabilité va au-delà du simple monitoring : il s’agit de pouvoir expliquer rapidement pourquoi un pipeline échoue, où une donnée est altérée, et comment y remédier.

L’intégration de l’IA dans la gouvernance et l’observabilité transforme profondément la façon dont on conçoit et maintient une Data Platform.

2.6.1 — Analyse accélérée et plus transparente des logs

Aujourd’hui, diagnostiquer un incident = parcourir des centaines de lignes de logs.

Avec l’IA, il devient possible d’interroger les logs en langage naturel :

> “Montre-moi les trois dernières erreurs critiques sur le pipeline X et explique-moi leur cause probable.”

Les agents IA consolident automatiquement les journaux, identifient les étapes problématiques, proposent des explications et des corrections. > Gain majeur en transparence et en rapidité.

Côté sécurité, il sera aussi possible d’interroger les logs pour savoir qui a accédé à quelle donnée.

2.6.2 — Self-healing pipelines

Les pipelines auto-réparateurs constituent l’une des applications les plus parlantes de l’observabilité augmentée par IA.

Un pipeline peut :

• détecter une anomalie,

• identifier la cause probable,

• exécuter une action corrective (relancer une tâche, remplacer une source, corriger une valeur incohérente),

• consigner toutes ces actions dans un log d’audit.

Résultat : moins d’incidents, moins de downtime, plus de valeur.

2.6.3 — Génération de tests qualité en langage naturel

Le maintien de tests pertinents est un défi permanent.

Avec l’IA, on peut décrire un besoin métier et générer automatiquement un jeu de tests adapté.

Exemple :

> “Crée un test qui vérifie que la somme des ventes par mois est cohérente avec la table de facturation, avec une tolérance de 1 %.”

Ce mécanisme permet d’itérer rapidement, de supprimer les tests obsolètes, et de garder une suite de contrôles utile et pertinente.

2.6.4 — Documentation dynamique et auto-complétée

Problème récurrent : Un autre problème récurrent des plateformes Data est la documentation partielle ou obsolète. L’IA pourra extraire et organiser automatiquement les métadonnées (colonnes, types, règles de calcul, transformations appliquées) pour maintenir :

Avec l’IA :

• extraction et organisation automatique des métadonnées,

• Des glossaires métier compréhensibles par tous,

• Une documentation de lignage précise, montrant comment chaque donnée a été produite,

• Des catalogues de données et de modèles à jour, intégrés dans les outils d’exploration.

C’est un changement de paradigme. Jusqu’ici, la gouvernance et observabilité étaient perçues comme un “fardeau” : chronophages, coûteux, et rarement considérés comme une priorité par rapport à la livraison de nouvelles features data. Avec l’IA, ces fonctions seront correctement réalisées car plus automatisées, dynamiques et intégrées au cycle de vie des données (CI/CD).

On passe :

• d’un contrôle a posteriori à une surveillance continue,

• d’une doc manuelle à une doc vivante,

• d’un monitoring réactif à un pilotage préventif.

C’est un changement qui ne se limite pas à l’outillage : il transforme la culture des équipes data, qui peuvent consacrer plus de temps à la valeur métier et moins aux tâches répétitives de maintenance.

KPIs impactés par l’IA (gouvernance & observabilité) :

• Qualité des données,

• Disponibilité des métiers,

• Adoption des données (meilleure documentation & gouvernance),

• Compliance légale et sécurité.

3. Impact sur le coût et les émissions carbone

3.1 — Coût financier

La GenAI a un impact significatif sur les coûts de fonctionnement des équipes Data et des Data Platform.

D’une part, elle fait baisser les coûts humains : beaucoup de tâches répétitives (documentation, monitoring, data quality checks, orchestration de workflows) peuvent être automatisées par des copilotes ou des modèles spécialisés. Les équipes Data peuvent donc se concentrer sur des missions à plus forte valeur ajoutée, ce qui permet de faire plus avec moins.

D’autre part, les coûts de fonctionnement vont augmenter drastiquement. La consommation de compute et de storage augmentera fortement avec l’usage croissant de la GenAI, notamment pour gérer de gros volumes de données et des workloads plus complexes. Il faut aussi prévoir l’ajout de nouvelles fonctionnalités IA sur les outils SaaS de la Modern Data Stack qui augmentent les coûts.

À cela s’ajoute une dépendance accrue aux hyperscalers, avec des GPU coûteux et des modèles souvent proposés sous forme de services managés. En pratique, on ne dépense pas forcément moins : on déplace la charge financière. Les coûts humains diminuent, mais les coûts liés à l’infrastructure et aux services cloud prennent le dessus. La priorité pour les entreprises sera donc d’intégrer une logique FinOps, afin d’arbitrer entre performance et optimisation budgétaire, et d’éviter que la GenAI ne devienne un centre de coûts incontrôlable.

En bref : La GenAI a un double effet :

- ↓ Coûts humains : automatisation des tâches répétitives (doc, monitoring, quality checks…).

- ↑ Coûts techniques : consommation accrue de compute et storage, ajout de fonctionnalités IA payantes dans la Modern Data Stack, dépendance aux hyperscalers et GPU coûteux.

On ne dépense pas moins : on déplace la charge financière. Les coûts humains diminuent, mais les coûts cloud explosent.

D’où l’importance d’une logique FinOps pour arbitrer entre performance et budget afin d’éviter que la GenAI ne devienne un centre de coûts incontrôlable.

3.2 — Impact carbone

La question environnementale est tout aussi centrale. La GenAI entraîne une hausse de la consommation énergétique des plateformes : les data centers consommaient déjà environ 400 TWh en 2024, et ce chiffre pourrait tripler d’ici 2030 avec les workloads IA. Certains superclusters atteignent même une consommation à l’échelle du gigawatt, équivalente à celle d’une grande ville.

Il faut cependant replacer ces chiffres dans leur contexte : une requête typique dans ChatGPT correspond à environ 0,03 g de CO₂e, quand une tasse de café en représente 21 g (700 requêtes ChatGPT = 1 café).

En comparaison, l’empreinte carbone unitaire reste faible. Surtout, la GenAI peut aussi contribuer à réduire l’impact global : optimisation énergétique dans l’industrie, réduction du gaspillage dans les supply chains, ou encore meilleure efficacité dans le transport et la logistique. L’enjeu n’est donc pas de diaboliser la GenAI, mais de l’utiliser de manière responsable. Cela suppose de construire des plateformes sobres : éviter les traitements et stockages inutiles, choisir le bon niveau de compute en fonction du cas d’usage, privilégier des modèles adaptés plutôt que de systématiquement appeler de gros LLM, et s’appuyer sur des data centers utilisant des énergies propres ou des solutions de cooling avancées. L’IA peut être à la fois un risque et un levier pour la durabilité. C’est la capacité des équipes Data à intégrer une approche responsable dans leur design et leurs pratiques qui fera la différence dans les années à venir.

En bref : La GenAI augmente fortement la consommation énergétique :

- Data centers → ~400 TWh en 2024, possible x3 d’ici 2030,

- Certains superclusters = 1 gigawatt (équivalent consommation d’une grande ville).

L’IA peut aussi réduire l’impact global :

• optimisation énergétique dans l’industrie,

• réduction du gaspillage supply chain,

• efficacité dans le transport et la logistique.

L’enjeu n’est donc pas de diaboliser la GenAI, mais de l’utiliser de manière responsable. Cela suppose de construire des plateformes sobres :

La clé = construire des plateformes sobres :

• éviter les traitements inutiles,

• calibrer le compute selon l’usage,

• privilégier des modèles adaptés plutôt que des LLM massifs,

• choisir des data centers verts (énergies propres, cooling avancé).

L’IA est à la fois un risque et un levier pour la durabilité.

Conclusion

La GenAI ne se limite pas à introduire de nouveaux outils : elle redéfinit en profondeur l’architecture et le fonctionnement des Data Platforms.

Chaque brique – de l’ingestion à l’orchestration, en passant par la transformation, le stockage, l’analytics et la gouvernance – est appelée à évoluer sous l’effet des copilotes, des agents autonomes et des approches plus dynamiques. Résultat : réduction des efforts manuels, accélération du time-to-insight, meilleure autonomie des équipes métier.

Mais ces innovations s’accompagnent aussi de défis majeurs. Les coûts financiers et énergétiques liés à l’usage intensif de l’IA vont croître, imposant une vigilance accrue en matière de FinOps et de durabilité. Et si les équipes Data peuvent “faire plus avec moins”, cela ne sera viable qu’à condition de s’appuyer sur un socle DataOps robuste, garantissant standards, gouvernance et cohérence. Sans cela, le risque est grand de bâtir des plateformes instables, coûteuses ou de recréer une nouvelle “usine à gaz” technologique.

En somme, cette première révolution guidée par la GenAI place les équipes Data devant un double impératif : exploiter la puissance de l’IA pour gagner en impact, tout en maîtrisant la complexité et la soutenabilité de leurs plateformes.

---

👉 Dans le prochain article de cette série – Impact de l’IA sur les équipes Data (2/3) : évolutions des rôles et responsabilités – nous explorerons comment ces transformations se traduisent concrètement sur l’organisation et les métiers des équipes Data, et quelles compétences seront nécessaires pour tirer parti de ce nouvel écosystème.

---

Et pour en savoir plus sur la Modern Data Stack, retrouvez notre masterclass inédite avec Robin Conquet de Data Gen ici !

Sources

- https://www.matillion.com/uploads/pdf/OReilly-Guide-April-2025.pdf

- https://medium.com/dataplatform-things/agentic-ai-for-data-engineering-reimagining-enterprise-data-management-with-ai-agents-1f0ec70b04da

- https://www.linkedin.com/feed/update/urn:li:activity:7349327857187176451/

- https://www.datacamp.com/tutorial/crew-ai

- https://juhache.substack.com/p/boring-semantic-layer-mcp

- https://arxiv.org/pdf/2507.07935

- https://blog.dataexpert.io/p/how-i-made-airbnb-millions-with-this

- https://ai.gopubby.com/ai-energy-paradox-powering-the-future-without-burning-it-down-752396678a6e

- https://www.wsj.com/articles/google-wants-you-to-know-the-environmental-cost-of-quizzing-its-ai-143cfe19