La montée en puissance des agents conversationnels en entreprise

Les agents conversationnels ne sont plus une curiosité technologique. Aujourd’hui, ils deviennent des leviers de performance concrets pour les entreprises : gain de temps, accès instantané à la connaissance interne, meilleure qualité de service, et réduction de la charge des équipes support. Mais alors, pourquoi développer son propre agent LLM plutôt que d’utiliser un assistant grand public comme ChatGPT ?

Ces outils sont génériques par nature : ils ne connaissent ni vos règles métiers, ni vos bases de données, ni vos contraintes réglementaires. Ils ne garantissent ni la confidentialité des données, ni une intégration fluide dans votre écosystème. Bref, ils brillent à l’extérieur, mais n’apportent pas de valeur différenciante en interne. C’est pourquoi de plus en plus d’équipes, métiers comme techniques choisissent de concevoir un agent conversationnel LLM sur mesure, hébergé dans un environnement sécurisé comme AWS Bedrock, pour répondre à leurs besoins spécifiques :

- Maîtriser les flux de données sensibles (RGPD, souveraineté)

- Adapter le langage à chaque métier

- Connecter l’agent aux outils internes (CRM, support, bases documentaires, etc.)

Dans ce guide, nous verrons comment concevoir un tel agent de bout en bout :

• Pourquoi cette approche devient stratégique ?

• Qu’est-ce que le RAG ?

• Comment AWS Bedrock vous permet de déployer un agent à la fois scalable, fiable et interne

• Use case RH - de l’idée au POC en production

Pourquoi mettre en place un agent conversationnel privé devient stratégique pour l’entreprise ?

Les entreprises ont de plus en plus d’outils. Trop, parfois. Une simple information peut se cacher dans un fichier, une base interne, un ticket ou une doc oubliée. Résultat : on peut perdre beaucoup de temps.

Un agent conversationnel bien conçu règle ce problème. Il comprend une question posée naturellement, et va chercher la bonne réponse, dans les bonnes sources. Sans avoir à cliquer partout et sans avoir à savoir où chercher.

Mais pour que cela fonctionne, il faut que cet agent connaisse l’entreprise : son vocabulaire, ses métiers, ses outils, ses documents. Un assistant générique tel que ChatGPT ne peut pas faire ceci. En effet, il ne comprend pas le contexte. Et surtout, il ne garantit pas que vos données restent entre vos murs.

C’est là que les solutions privées prennent tout leur sens comme celles qu’on peut construire avec les plateformes cloud tel que AWS. L’agent est déployé dans votre environnement, il apprend ce que vous décidez de lui apprendre, et surtout, aucune donnée ne sort.

Les agents conversationnels ne sont pas de simples outils. En effet, ce sont de véritables leviers pour gagner du temps, réduire les frictions, et rendre chaque équipe plus autonome, au quotidien.

Qu’est ce que le RAG (Retrieval-Augmented Generation) ?

Lorsque l’on pense à l’IA générative, on pense souvent à des outils comme ChatGPT, Claude, Gemini etc. Ces modèles sont capables de formuler des réponses claires, parfois même bluffantes. Mais il y a un problème : ils n’ont pas toujours accès aux bonnes informations.

En effet, ils répondent en s’appuyant sur ce qu’ils ont appris pendant leur entraînement et ça s’arrête souvent à une certaine date. Par conséquent, cela peut poser des problèmes car ils peuvent halluciner, donner des réponses obsolètes ou simplement inexactes pour un cas d’usage métier.

C’est là qu’intervient le RAG, pour Retrieval-Augmented Generation. Le principe est simple : avant de répondre, l’agent va chercher les bonnes infos dans une base de connaissances. Puis il s’appuie sur ces infos pour générer sa réponse.

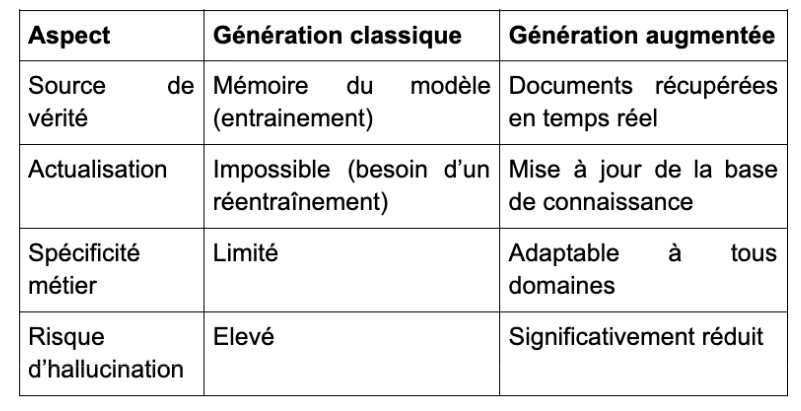

Le tableau ci-dessous résume ce qu’apporte le RAG par rapport à une génération classique d’un modèle tel que Chat GTP :

Avant de répondre, l’agent va d’abord chercher dans vos contenus, i.e., contrats, FAQ internes, manuels techniques, documents RH se trouvant dans la base de connaissance. Puis il s’appuie sur ce qu’il trouve pour formuler une réponse claire et ciblée.

Concrètement, ça change tout ! Moins de réponses 'inventées', car le modèle s’appuie sur des sources que vous maîtrisez. Des infos justes et à jour, même si le document a changé hier ainsi qu’un langage métier, adapté à votre contexte, vos règles et vos sujets. Pas de réentraînement à chaque mise à jour : vous remplacez un fichier, l’agent s’ajuste.

Comment déployer un agent conversationnel sur AWS avec une architecture RAG ?

Maintenant que l’on comprend mieux ce qu’est un agent conversationnel et pourquoi le RAG est essentiel, passons à quelque chose de plus concret : comment créer un tel agent ? Pour ce faire nous allons choisir la plateforme cloud AWS.

Pourquoi AWS Bedrock est un bon choix ?

Déployer un agent conversationnel, ce n’est pas juste choisir un modèle. C’est aussi penser à la sécurité, à l’évolutivité, à l’intégration, et à la gouvernance. Sur tous ces aspects, AWS Bedrock s’impose comme une solution solide :

Pas besoin de gérer les modèles vous-même :

Avec Bedrock, vous accédez à plusieurs modèles (Anthropic, Meta, Mistral, etc.) via API. Aucun besoin de déployer d’infrastructure, de gérer du GPU, ou de scaler manuellement. C’est idéal pour prototyper rapidement… et industrialiser ensuite.

Les données restent chez vous :

Les prompts, les documents et les logs sont traités dans votre environnement AWS. Rien n’est stocké, rien n’est réutilisé pour entraîner les modèles. C’est un vrai plus en matière de RGPD et de confidentialité métier.

L’agent s’intègre nativement à votre système :

IAM, S3, Lambda, EventBridge, CloudWatch… toutes ces briques AWS peuvent être utilisées pour tracer les appels, automatiser les flux et maîtriser les accès. L’agent devient un composant de votre SI, et non une boîte noire.

Une architecture pensée pour l’évolution :

Vous pouvez commencer petit (un cas d’usage interne, une FAQ intelligente), puis ajouter de la mémoire, des accès métiers ou de nouvelles sources de données sans tout casser. L’infrastructure est déjà prête pour monter en charge.

Une fois le cas d’usage clarifié et les données préparées, il est temps de passer à la conception technique. Pour garantir performance, robustesse et évolutivité, l’agent conversationnel doit s’appuyer sur une architecture bien structurée, composée de quatre blocs complémentaires. Chacun joue un rôle spécifique, et c’est leur combinaison qui permet à l’agent de fonctionner de manière fluide, sécurisée, et pleinement intégrée à votre environnement, ici, AWS.

L’architecture repose sur 4 grands blocs fonctionnels :

- L’interface utilisateur (frontend):

C’est le point d’entrée, là où l’utilisateur pose sa question. Cela peut être un chat intégré à un site web, une interface sur l’intranet, ou encore des outils comme Slack ou Microsoft Teams.

- Pipeline de traitement des données :

C’est le cœur du traitement des données. Ce bloc gère l’ingestion, la transformation et le nettoyage des fichiers métiers (PDF, Excel, exports de CRM, etc.). Une fois préparées, les données sont stockées dans une landing zone (souvent sur Amazon S3, avec un format comme Apache Iceberg) pour être exploitées ultérieurement.

- Le moteur RAG :

Ce composant extrait les contenus pertinents depuis la landing zone, les découpe, les vectorise (via un modèle d’embedding), puis les stocke dans une base vectorielle (ici, Amazon OpenSearch Serverless). Cette base devient notre mémoire métier à laquelle le LLM pourra se connecter.

- L’agent conversationnel :

C’est le visage de l’IA. Il est orchestré via Amazon Bedrock, configuré pour interagir avec le LLM et consulter la base vectorielle lorsque c’est nécessaire. L’agent comprend les requêtes en langage naturel, récupère les bons documents via la recherche augmentée (RAG), et génère une réponse fiable et contextualisée.

Cette architecture vous apporte des garanties concrètes à plusieurs niveaux. D’abord, elle assure une scalabilité automatique, effectivement, les services managés tels que Lambda, API Gateway ou Bedrock s’adaptent dynamiquement à la charge, sans nécessiter de gestion manuelle de l’infrastructure. Elle garantit également une sécurité native, grâce à un contrôle rigoureux des accès via IAM et à un strict confinement des données au sein de votre environnement AWS, ce qui assure confidentialité et conformité. Enfin, son extensibilité vous permet d’enrichir facilement l’architecture avec de nouvelles règles métiers comme des filtres, une mémoire d’historique, des validations ou d’ajouter des sources de données, sans avoir à remettre en question le socle existant.

Elle répond ainsi aux principales exigences des systèmes d’information modernes : des performances élevées, même en cas de montée en charge, une protection des données conforme au RGPD , et une traçabilité complète, facilitant les audits et le monitoring. En résumé, vous gardez la maîtrise de vos données et de votre infrastructure, tout en tirant parti de la puissance d’un agent conversationnel parfaitement aligné sur vos cas d’usage métier.

Use case : créer un agent pour accompagner les équipes RH

Contexte

Une entreprise souhaiterait aider son service RH à mieux gérer les questions internes. Les sujets sont classiques : congés, télétravail, formations, etc. Plutôt que de répondre à chaque mail ou message, l’idée est de mettre en place un agent capable de donner des réponses simples, à partir des documents existants.

Stockage des documents

Tous les fichiers RH sont déposés dans un bucket Amazon S3. Ça peut être des PDF, des fichiers Word ou Excel. L’important, c’est qu’ils soient à jour et bien nommés.

Indexation des contenus

Un traitement automatique lit les documents, extrait le texte et le découpe en petits blocs. Chaque bloc est transformé en un vecteur numérique à l’aide d’un modèle comme: multi-qa-mpnet-base-dot-v1. Ces vecteurs sont ensuite enregistrés dans Amazon OpenSearch Serverless, qui devient la base de connaissance de l’agent.

Configuration de l’agent

L’agent est créé avec Amazon Bedrock. On choisit un modèle LLM, comme Claude, Titan ou Mistral. On lui donne des instructions claires :

« Tu es un assistant RH. Tu dois t’appuyer uniquement sur les documents internes. Si tu ne trouves pas la réponse, tu peux faire une recherche sur Internet. »

Ces consignes permettent de cadrer le comportement de l’agent dès le départ.

Déploiement

L’agent est exposé via une API Gateway. On peut aussi l’intégrer directement dans une messagerie interne comme Slack, ou dans une app web RH déjà existante.

Exemple d’interaction avec l’agent :

Notre vison :

Les agents conversationnels, autrefois réservés aux grandes entreprises, sont désormais accessibles à tous. Ils transforment en profondeur notre manière d’accéder à l’information et apportent une réelle valeur au quotidien des collaborateurs et ce, quelle que soit la taille de l’organisation. Qu’il s’agisse de gagner du temps, de réduire la charge de travail liée à des demandes répétitives, ou encore de centraliser la connaissance métier, un agent conversationnel bien conçu devient un véritable levier pour l’organisation.

La solution proposée, basée sur une architecture modulaire sur AWS, démontre qu’il est possible de passer de l’ingestion brute des documents jusqu’à l’interaction intelligente avec un agent minutieusement configuré sur Amazon Bedrock. En intégrant un moteur RAG, l’agent s’appuie sur des sources fiables et actualisées, réduisant ainsi le risque d’hallucination des modèles LLM classiques tout en offrant une adaptabilité parfaite aux besoins métiers spécifiques.

Cependant, à mesure que l’IA générative évolue, il devient nécessaire de nuancer l’enthousiasme autour du RAG. La taille des prompts pouvant désormais dépasser plusieurs dizaines de milliers de tokens, et le coût des appels API ayant significativement baissé, certaines situations peuvent justifier une approche plus directe. Injecter le contexte métier dans un prompt bien structuré, sans pipeline RAG complexe, peut s’avérer plus simple, plus rapide, et parfois plus économique. Autrement dit, RAG n’est pas toujours la réponse idéale : tout dépend du volume, de la fréquence des requêtes, et du niveau de personnalisation requis.

Cette réflexion ouvre la voie à un questionnement plus large : comment orchestrer efficacement les briques d’IA générative au sein d’un système d’information ? Et surtout, quel rôle joue le data engineering dans cette nouvelle équation ?

Pour aller plus loin, découvrez notre article : GenAI : le rôle stratégique du Data Engineering